Ogni anno circa 7 milioni di bambini vengono denunciati alle autorità preposte al benessere dei bambini per possibili abusi, ma in che modo le autorità determinano se ai bambini piace Gabriel Fernandez sono in grave pericolo e necessitano di intervento?

Molte autorità preposte al benessere dei bambini fanno affidamento sulle valutazioni del rischio fornite da personale addestrato a presidiare le linee telefoniche in cui viene segnalato un sospetto abuso, ma alcuni ritengono che possa esserci un modo migliore.

le colline hanno occhi storia vera

'C'è un'ampia letteratura che abbiamo visto che suggerisce che gli esseri umani non sono sfere di cristallo particolarmente buone', Emily Putnam-Hornstein, direttrice del Rete dati per bambini e un professore associato alla USC, ha detto nella nuova serie di docu di Neflix 'The Trials of Gabriel Fernandez'. 'Invece, quello che stiamo dicendo è addestrare un algoritmo per identificare quale di quei bambini si adatta a un profilo in cui il rischio di arco lungo suggerirebbe un futuro coinvolgimento del sistema'.

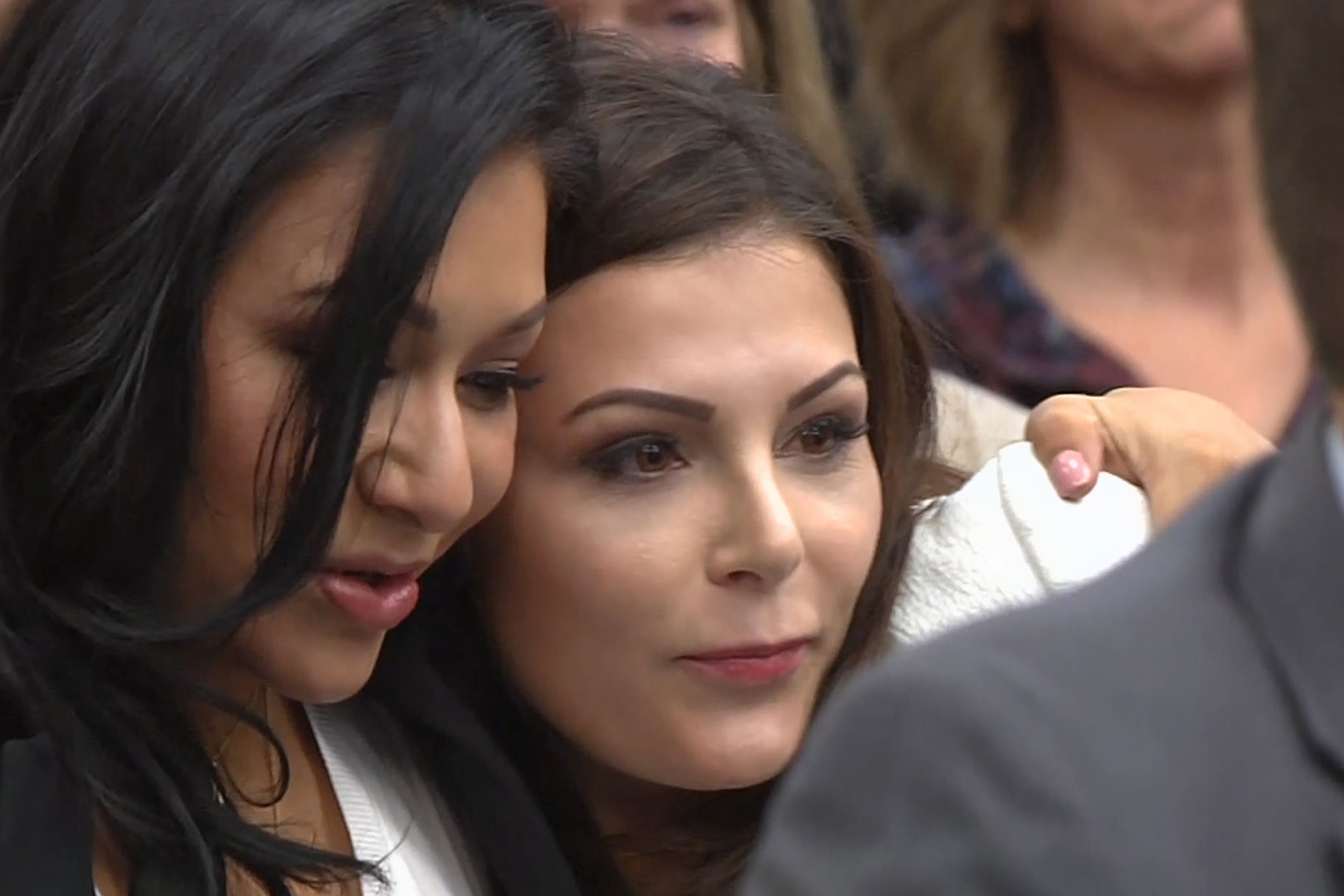

Fernandez era un bambino di 8 anni picchiato e torturato a morte dal suo madre e lei fidanzato , nonostante le ripetute chiamate del suo insegnante e di altri alle autorità che denunciano sospetti abusi. La nuova serie in sei parti esamina la vita e la morte orribile di Fernandez, ma offre anche uno sguardo più ampio problemi sistemici all'interno del sistema di assistenza all'infanzia che avrebbe potuto svolgere un ruolo.

Putnam-Hornstein sostiene che una strategia per identificare in modo più efficace i bambini a maggior rischio potrebbe essere quella di utilizzare algoritmi creati appositamente che utilizzano record amministrativi e data mining per determinare i punteggi di rischio per ogni bambino.

'In realtà abbiamo circa 6 o 7 milioni di bambini che vengono segnalati per presunti abusi o abbandono ogni anno negli Stati Uniti e storicamente il modo in cui abbiamo preso alcune delle nostre decisioni di screening si basa solo sul tipo di valutazioni intestinali', ha detto. 'La modellazione del rischio predittivo sta solo dicendo: 'No, no, no, adottiamo un approccio più sistematico ed empirico a questo.''

Putnam-Hornstein e Rhema Vaithianathan, il co-direttore del Centro per l'analisi dei dati sociali , sono stati in grado di mettere in pratica l'idea nella contea di Allegheny, in Pennsylvania. La coppia ha utilizzato migliaia di segnalazioni di maltrattamento sui minori per progettare un algoritmo che determinasse un punteggio di rischio per ogni famiglia segnalata ai servizi di protezione dei minori della contea, secondo il Centro per il giornalismo sanitario .

peterson ha ucciso la moglie a durham nc

'Ci sono un centinaio di fattori diversi che vengono presi in considerazione', ha spiegato Marc Cherna, direttore del Dipartimento dei servizi umani della contea di Allegheny, nella serie di docu. 'Alcuni esempi di base sono la storia del benessere dei bambini, la storia dei genitori, certamente l'uso di droghe e la dipendenza, la malattia mentale familiare, la prigione e le condanne, e soprattutto se ci sono aggressioni e cose del genere'.

A causa dell'elevato volume di chiamate, le autorità per il benessere dei bambini in tutto il paese hanno il compito di determinare se una famiglia debba essere sottoposta a screening per indagini sulla base della denuncia o essere esclusa.

Nel 2015, il 42% dei 4 milioni di accuse ricevute in tutto il paese riguardanti 7,2 milioni di bambini è stato escluso, secondo Il New York Times .

Tuttavia, i bambini continuano a morire per abusi sui minori.

Il sistema utilizzato nella contea di Allegheny è progettato per prevedere in modo più accurato quali famiglie potrebbero avere un futuro coinvolgimento del sistema attraverso l'analisi dei dati.

'Quello che hanno gli screeners sono molti dati', ha detto Vaithianathan al Times. 'Ma è abbastanza difficile navigare e sapere quali sono i fattori più importanti. All'interno di una singola chiamata a C.Y.F. , potresti avere due figli, un presunto colpevole, avrai una mamma, potresti avere un altro adulto in famiglia: tutte queste persone avranno delle storie nel sistema che la persona che controlla la chiamata può indagare. Ma il cervello umano non è così abile nell'imbrigliare e dare un senso a tutti i dati '.

Lo strumento di screening della famiglia Allegheny utilizza una tecnica statistica chiamata 'data mining' per esaminare i modelli storici per 'cercare di fare una previsione su ciò che potrebbe accadere' in ogni caso, ha detto nella serie di docu.

i record del braccio della morte sono ancora in circolazione

A ogni caso viene assegnato un punteggio di rischio compreso tra uno e 20, classificando ogni caso come ad alto rischio, medio o basso rischio.

Rachel Berger, pediatra presso il Children’s Hospital di Pittsburgh, ha dichiarato al Times nel 2018 che ciò che rende preziosa l'analisi predittiva è che elimina parte della soggettività tipica del processo.

'Tutti questi bambini vivono nel caos', ha detto. “In che modo C.Y.F. scegliere quali sono più in pericolo quando hanno tutti fattori di rischio? Non puoi credere alla quantità di soggettività che va nelle decisioni sulla protezione dei minori. Ecco perché amo l'analisi predittiva. Sta finalmente portando un po 'di oggettività e scienza alle decisioni che possono cambiare così incredibilmente la vita. '

Ma ci sono stati anche critici che sostengono che l'uso dell'analisi predittiva si basa su dati che potrebbero già essere distorti. Ricerche passate hanno dimostrato che le minoranze e le famiglie a basso reddito sono spesso sovrarappresentate nei dati raccolti, creando potenzialmente un pregiudizio nei confronti delle famiglie afro-americane o di altre famiglie minoritarie, secondo la serie di documenti.

“I pregiudizi umani e i pregiudizi sui dativanno di pari passo l'uno con l'altro'Kelly Capatosto, un ricercatore associato senior presso il Kirwan Institute for the Study of Race and Ethnicity presso la Ohio State University, ha detto, secondo il Center for Health Journalism. “Con queste decisioni, pensiamo alla sorveglianza e al contatto con il sistema - con la polizia, le agenzie di assistenza all'infanzia, qualsiasi agenzia di assistenza sociale. Sarà sovrarappresentato nelle comunità (a basso reddito e minoritarie). Non è necessariamente indicativo di dove si stanno verificando questi casi. '

Erin Dalton, vicedirettore dell'ufficio di analisi, tecnologia e pianificazione della contea di Allegheny, ha ammesso che il bias è possibile.

come ha fatto Ice a incontrare Coco

“Di sicuro, nei nostri sistemi ci sono dei pregiudizi. Gli abusi sui minori sono visti da noi e dai nostri dati come non una funzione dell'effettivo abuso sui minori, è una funzione di chi viene segnalato ', ha detto nella serie Netflix.

Ma la contea ha anche detto al Center for Health Journalism di aver scoperto che ricevere benefici pubblici abbassa i punteggi di rischio per quasi le sue famiglie.

TLa contea è 'molto sensibile' a questa preoccupazione e sta conducendo analisi continue sul sistema per determinare se i gruppi sono stati presi di mira in modo sproporzionato, ha detto anche Cherna nella serie di documenti.

Il sistema della contea di Allegheny è di proprietà della contea stessa, ma ci sono state anche alcune critiche nei confronti di altri sistemi di screening di proprietà privata.

L'Illinois Department of Children and Family Services ha annunciato nel 2018 che non avrebbe più utilizzato un pacchetto di analisi predittiva sviluppato da Eckerd Connects, un'organizzazione no profit, e dal suo partner a scopo di lucro MindShare Technology, in parte perché la società ha rifiutato di fornire dettagli su quali fattori sono stati utilizzati nella loro formula, secondo The Times.

Secondo quanto riferito, il sistema ha iniziato a designare migliaia di bambini bisognosi di protezione urgente, dando a oltre 4.100 bambini dell'Illinois una probabilità del 90% o superiore di morte o lesioni, Il Chicago Tribune segnalato nel 2017.

Tuttavia, altri bambini che non hanno ricevuto punteggi di rischio elevato sono comunque morti per abusi.

'L'analisi predittiva (non era) predittiva di nessuno dei casi gravi', 'B.J.', direttrice del Department of Children and Family Services Walker ha detto al Tribune. 'Ho deciso di non procedere con quel contratto.'

Daniel Hatcher, autore di ' L'industria della povertà: lo sfruttamento dei cittadini più vulnerabili d'America 'Ha confrontato alcuni dei sistemi analitici con una' scatola nera ', dicendo nella serie di docu che il modo in cui prendono le loro decisioni non è sempre chiaro.

upstate new york serial killer 1970

'Non hanno modo di capire come stanno effettivamente decidendo un livello di cura che ha un enorme impatto su un individuo', ha detto.

Putnam-Hornstein ha riconosciuto che i sistemi analitici predittivi non sono in grado di determinare il comportamento futuro, ma crede che sia uno strumento prezioso che consente agli esaminatori di prendere decisioni più informate su quali bambini potrebbero essere a maggior rischio.

'La mia speranza è che questi modelli aiuteranno il nostro sistema a prestare maggiore attenzione al sottoinsieme relativamente piccolo di rinvii in cui il rischio è particolarmente alto e saremo in grado di dedicare più risorse a quei bambini e famiglie in modo preventivo', ha detto, secondo al Center for Health Journalism. 'Non voglio che nessuno venda troppo i modelli di rischio predittivo. Non è una sfera di cristallo. Non risolverà tutti i nostri problemi. Ma a margine, se ci permette di prendere decisioni leggermente migliori e identificare i casi ad alto rischio e separare quelli dai casi a basso rischio e aggiustare di conseguenza, questo potrebbe essere uno sviluppo importante per il campo '.